क्यू-लर्निंग का परिचय [Introduction to Q-Learning]

क्यू-लर्निंग सुदृढीकरण सीखने की आधारशिला है, जो मशीन लर्निंग का एक उपक्षेत्र है। यह एक मॉडल-मुक्त एल्गोरिदम है जो एजेंटों (जैसे रोबोट या AI सिस्टम) को उनके कार्यों के परिणामों से सीखकर किसी वातावरण में निर्णय लेने की अनुमति देता है। अन्य एल्गोरिदम के विपरीत, क्यू-लर्निंग को पर्यावरण के मॉडल की आवश्यकता नहीं होती है, बल्कि इसके बजाय निर्णय लेने की प्रक्रियाओं को अनुकूलित करने के लिए परीक्षण-और-त्रुटि सीखने पर निर्भर करता है।

इस ब्लॉग पोस्ट में, हम क्यू-लर्निंग में गहराई से उतरेंगे, यह पता लगाएंगे कि यह कैसे काम करता है, इसके फायदे और नुकसान, वास्तविक दुनिया के अनुप्रयोग, और कुछ अक्सर पूछे जाने वाले प्रश्नों के उत्तर देंगे। यदि आप सुदृढीकरण सीखने के लिए नए हैं, तो यह मार्गदर्शिका आपको यह समझने में मदद करेगी कि क्यू-लर्निंग AI में निर्णय लेने के कार्यों के लिए उपयोग किए जाने वाले सबसे शक्तिशाली एल्गोरिदम में से एक क्यों है।

क्यू-लर्निंग क्या है? [What is Q-Learning?]

क्यू-लर्निंग एक मॉडल-मुक्त सुदृढीकरण सीखने वाला एल्गोरिदम है जिसका उपयोग किसी दिए गए कार्य के लिए इष्टतम क्रिया-चयन नीति खोजने के लिए किया जाता है। यह आमतौर पर ऐसे वातावरण में लागू किया जाता है जहाँ एजेंट को संचयी इनाम की कुछ धारणा को अधिकतम करने के लिए क्रमिक रूप से निर्णय लेने चाहिए।

Q-लर्निंग में, "Q" का अर्थ गुणवत्ता है। Q-मूल्य किसी विशेष स्थिति में किसी दिए गए कार्य के लिए अपेक्षित भविष्य के इनाम का प्रतिनिधित्व करता है, जिससे एजेंट को यह तय करने में मदद मिलती है कि आगे कौन सी कार्रवाई करनी है। Q-लर्निंग का लक्ष्य प्रशिक्षण के दौरान Q-मूल्यों के अपने ज्ञान को अपडेट करके समय के साथ कुल इनाम को अधिकतम करने वाली कार्रवाई को खोजना है।

Q-लर्निंग कैसे काम करता है

- State (S): पर्यावरण की वर्तमान स्थिति।

- Action (A): एजेंट द्वारा प्रत्येक चरण पर लिया गया निर्णय।

- Reward (R): कार्रवाई करने के बाद तत्काल प्रतिक्रिया।

- Q-Value (Q(s, a)): State S में Action A करने के लिए अपेक्षित संचयी इनाम (expected cumulative reward)।

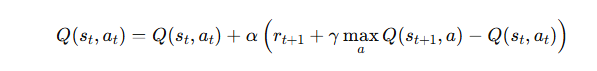

Q-लर्निंग एल्गोरिदम निम्नलिखित समीकरण का उपयोग करके Q-मूल्यों को अपडेट करता है:

Where:

- α is the learning rate.

- γ is the discount factor.

- rt+1 is the reward after taking action αt in state st.

इस पुनरावृत्त प्रक्रिया के माध्यम से, क्यू-लर्निंग एजेंट समय के साथ अपने कार्य विकल्पों में सुधार करता है, धीरे-धीरे इष्टतम नीति में परिवर्तित होता है।

क्यू-लर्निंग के लाभ [Advantages of Q-Learning]

क्यू-लर्निंग एक मजबूत और बहुमुखी सुदृढीकरण सीखने का एल्गोरिदम है जिसमें कई विशिष्ट लाभ हैं, जिसने इसे विभिन्न एआई अनुप्रयोगों में लोकप्रिय बना दिया है।

1. मॉडल-मुक्त सीखना [Model Free Learning]

अन्य सुदृढीकरण सीखने के एल्गोरिदम के विपरीत, जिन्हें पर्यावरण की गतिशीलता के ज्ञान की आवश्यकता होती है, क्यू-लर्निंग मॉडल-मुक्त है। यह इसे अत्यधिक लचीला बनाता है, क्योंकि यह किसी भी वातावरण में काम कर सकता है जहाँ एजेंट अपने कार्यों के परिणामों का निरीक्षण कर सकता है, पर्यावरण के पीछे के मॉडल को स्पष्ट रूप से जानने की आवश्यकता के बिना।

2. लागू करने में सरल [Simple to Implement]

क्यू-लर्निंग का एल्गोरिदम अपेक्षाकृत सरल है और इसे विभिन्न कार्यों में लागू किया जा सकता है। चूँकि इसे पर्यावरण के मॉडल की आवश्यकता नहीं है, इसलिए इसे मॉडल-आधारित विधियों की तुलना में लागू करना आसान है, जिसके लिए पर्यावरण की गहरी समझ की आवश्यकता होती है।

3. इष्टतम नीति के लिए अभिसरण [Convergence to Optimal Policy]

पर्याप्त समय और अनुभव दिए जाने पर, क्यू-लर्निंग इष्टतम क्रिया-चयन नीति के लिए अभिसरण की गारंटी है, बशर्ते सीखने की दर और अन्वेषण संतुलित हों। यह इसे निर्णय लेने वाले कार्यों के लिए अत्यधिक विश्वसनीय बनाता है जहाँ इष्टतमता महत्वपूर्ण है।

4. अनुप्रयोगों में बहुमुखी प्रतिभा [Versatility in Applications]

क्यू-लर्निंग को वीडियो गेम से लेकर रोबोटिक्स और यहाँ तक कि वित्तीय निर्णय लेने तक के विभिन्न निर्णय लेने वाले कार्यों में लागू किया जा सकता है, जो इसे AI में एक अविश्वसनीय रूप से बहुमुखी एल्गोरिदम बनाता है।

क्यू-लर्निंग के नुकसान [Disadvantages of Q-Learning]

जबकि क्यू-लर्निंग के कई लाभ हैं, यह कुछ सीमाओं के साथ भी आता है जिन पर विचार करने की आवश्यकता है।

1. अन्वेषण-शोषण दुविधा [Exploration-Exploitation Dilemma]

क्यू-लर्निंग की प्रमुख चुनौतियों में से एक अन्वेषण और शोषण के बीच व्यापार-बंद है। एजेंट को बेहतर पुरस्कार (अन्वेषण) की खोज करने के लिए नई क्रियाओं का पता लगाने की आवश्यकता होती है, साथ ही पुरस्कार (शोषण) को अधिकतम करने के लिए पहले से मौजूद ज्ञान का दोहन भी करना होता है। इस व्यापार-बंद को संतुलित करना मुश्किल हो सकता है, और अनुचित प्रबंधन से उप-इष्टतम प्रदर्शन हो सकता है।

2. स्केलेबिलिटी मुद्दे [Scalability Issues]

क्यू-लर्निंग अपेक्षाकृत छोटे राज्य और क्रिया स्थान वाले वातावरण में अच्छी तरह से काम करता है, लेकिन जैसे-जैसे राज्य स्थान बढ़ता है, एल्गोरिथ्म कम कुशल होता जाता है। यह सभी राज्य-क्रिया जोड़ों के लिए क्यू-मानों को संग्रहीत और अद्यतन करने की आवश्यकता के कारण है, जो संभावित राज्यों और क्रियाओं की संख्या बढ़ने के साथ कम्प्यूटेशनल रूप से महंगा हो सकता है। Deep Q-Network (DQN) क्या है?

3. धीमा अभिसरण [Slow Convergence]

बड़े वातावरण या कई राज्यों वाले कार्यों में, क्यू-लर्निंग को एक इष्टतम नीति में अभिसरित होने के लिए महत्वपूर्ण समय की आवश्यकता हो सकती है। वास्तविक समय प्रणालियों से निपटने के दौरान यह धीमी सीखने की प्रक्रिया एक चुनौती हो सकती है।

क्यू-लर्निंग के वास्तविक-विश्व अनुप्रयोग [Real-World Applications of Q-Learning]

क्यू-लर्निंग की सरलता और बहुमुखी प्रतिभा इसे विभिन्न वास्तविक-विश्व अनुप्रयोगों के लिए एक आदर्श एल्गोरिथ्म बनाती है। नीचे कुछ उल्लेखनीय उदाहरण दिए गए हैं कि विभिन्न डोमेन में क्यू-लर्निंग का उपयोग कैसे किया जाता है:

1. वीडियो गेम (Video Games)

क्यू-लर्निंग का व्यापक रूप से वीडियो गेम खेलने वाले AI सिस्टम में उपयोग किया गया है। उदाहरण के लिए, अटारी गेम में, क्यू-लर्निंग एजेंटों को उनके कार्यों के परिणामों से सीखकर पोंग और ब्रेकआउट जैसे गेम खेलने के लिए प्रशिक्षित किया गया है। ये सिस्टम अपने गेमप्ले को परीक्षण और त्रुटि से बेहतर बनाना सीखते हैं, अपने कार्यों से प्राप्त पुरस्कारों के आधार पर इष्टतम चालें बनाते हैं।

2. रोबोटिक्स (Robotics)

रोबोटिक्स में, क्यू-लर्निंग स्वायत्त रोबोट को गतिशील वातावरण में निर्णय लेने में मदद कर सकता है। उदाहरण के लिए, एक रोबोट भूलभुलैया में नेविगेट करते समय या वस्तुओं को इकट्ठा करते समय यह तय करने के लिए क्यू-लर्निंग का उपयोग कर सकता है कि आगे क्या कार्रवाई करनी है। प्रत्येक इंटरैक्शन के साथ अपने क्यू-वैल्यू को अपडेट करके, रोबोट समय के साथ अपनी निर्णय लेने की प्रक्रिया में सुधार करता है।

3. सेल्फ-ड्राइविंग कार (Self Driving Cars)

स्व-ड्राइविंग कारें जटिल ट्रैफ़िक वातावरण से गुजरने के लिए निर्णय लेने वाले एल्गोरिदम पर निर्भर करती हैं। क्यू-लर्निंग इन कारों को ड्राइविंग रणनीतियों को अनुकूलित करने का तरीका सीखने में मदद कर सकती है, जैसे ट्रैफ़िक लाइट पर कब रुकना है या बाधाओं से कैसे बचना है।

4. वित्तीय पोर्टफोलियो प्रबंधन (Financial Portfolio Management)

क्यू-लर्निंग को वित्तीय निर्णय लेने में लागू किया गया है, जैसे पोर्टफोलियो प्रबंधन रणनीतियों को अनुकूलित करना। ऐतिहासिक बाजार डेटा के साथ बातचीत करके, एक क्यू-लर्निंग एजेंट जोखिम को न्यूनतम करते हुए रिटर्न को अधिकतम करने के लिए सर्वोत्तम रणनीति सीख सकता है।

अक्सर पूछे जाने वाले प्रश्न (FAQ) [Frequently Asked Questions (FAQs) About Q-Learning]

1. Q-लर्निंग की मुख्य सीमाएँ क्या हैं?

मुख्य सीमाओं में उच्च-आयामी अवस्था स्थानों में इसकी अक्षमता, बड़े वातावरण में धीमी अभिसरण और अन्वेषण और शोषण को संतुलित करने की चुनौती शामिल है।

2. Q-लर्निंग अन्य सुदृढीकरण सीखने के एल्गोरिदम से कैसे भिन्न है?

Q-लर्निंग मॉडल-मुक्त है और इसके लिए पर्यावरण की गतिशीलता के ज्ञान की आवश्यकता नहीं होती है, जबकि मॉडल-आधारित एल्गोरिदम कार्यों की योजना बनाने के लिए पर्यावरण के मॉडल को सीखने या अनुमान लगाने का प्रयास करते हैं।

3. क्या Q-लर्निंग का उपयोग निरंतर वातावरण में किया जा सकता है?

Q-लर्निंग का उपयोग आम तौर पर असतत वातावरण में किया जाता है, लेकिन डीप Q-लर्निंग (DQN) और निरंतर Q-लर्निंग जैसे एक्सटेंशन निरंतर स्थितियों और क्रियाओं को संभालने के लिए तंत्रिका नेटवर्क या फ़ंक्शन अनुमानक का उपयोग करते हैं।

निष्कर्ष (Conclusion)

Q-लर्निंग एक शक्तिशाली और व्यापक रूप से उपयोग किया जाने वाला सुदृढीकरण सीखने का एल्गोरिदम है जो एजेंटों को जटिल, अनिश्चित वातावरण में इष्टतम व्यवहार सीखने में मदद करता है। परीक्षण और त्रुटि के माध्यम से पुरस्कारों से सीखकर, क्यू-लर्निंग गेमिंग से लेकर रोबोटिक्स और वित्त तक कई तरह की वास्तविक दुनिया की समस्याओं को हल कर सकता है।

हालाँकि बड़े पैमाने के वातावरण में इसकी अपनी सीमाएँ हैं, क्यू-लर्निंग अपनी सादगी, सैद्धांतिक गारंटी और अनुप्रयोग में लचीलेपन के कारण सुदृढीकरण सीखने की आधारशिला बनी हुई है। क्यू-लर्निंग कैसे काम करती है और इसकी मुख्य अवधारणाएँ, जैसे बेलमैन समीकरण और अन्वेषण-शोषण व्यापार-नापसंद, सुदृढीकरण सीखने की दुनिया में गोता लगाने वाले किसी भी व्यक्ति के लिए महत्वपूर्ण है।

Post a Comment

Blogger FacebookYour Comment Will be Show after Approval , Thanks